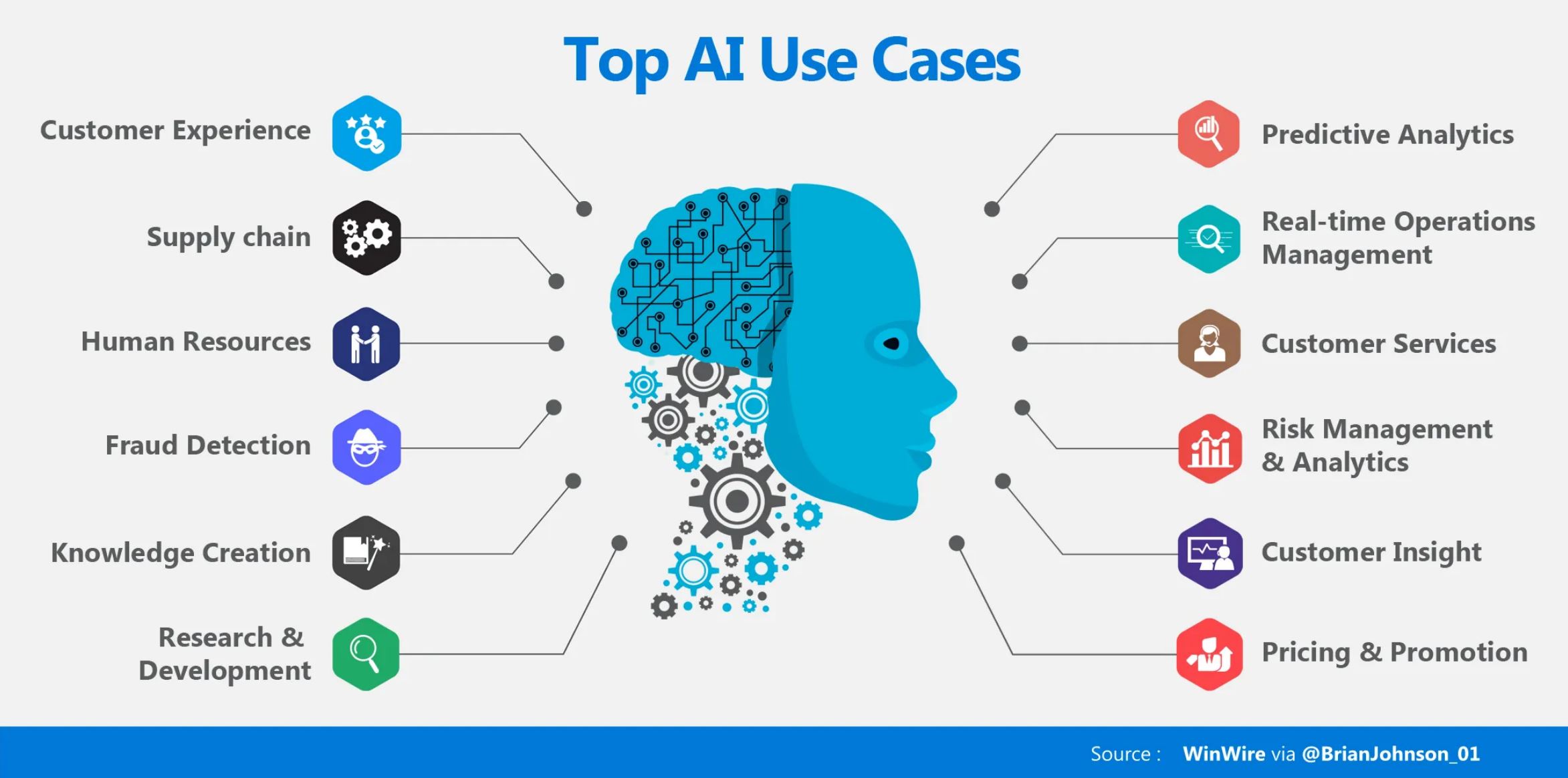

L’intelligence artificielle n’est plus un sujet réservé aux ingénieurs en hoodie ou aux start-up californiennes. Elle est déjà dans vos outils marketing, vos logiciels RH, vos CRM, vos moteurs de recommandation… parfois sans que vous en ayez pleinement conscience.

Et comme toute technologie qui transforme profondément l’économie, l’IA attire rapidement une autre espèce très organisée : le régulateur.

Entre l’entrée en vigueur de l’AI Act européen, les tensions avec les États-Unis, les prises de position de l’ONU, et les inquiétudes sur l’emploi, beaucoup de dirigeants ont le même réflexe :

“On n’y comprend rien, ça a l’air compliqué, on verra plus tard.”

Mauvaise nouvelle : plus tard, c’est maintenant.

Bonne nouvelle : ce n’est ni aussi technique, ni aussi effrayant qu’on veut bien le dire.

Dans cet article, on va poser les bases, calmement, avec des mots simples, pour que toute entreprise, même sans culture tech, comprenne :

- ce qu’est réellement l’AI Act,

- pourquoi les Américains grincent des dents,

- ce que ça change pour l’emploi,

- et surtout quoi faire concrètement, sans devenir juriste ou data scientist.

Sommaire

ToggleL’AI Act : le nouveau « cadre de jeu » européen

Une loi pensée pour les entreprises… pas pour les bloquer

L’AI Act, entré en application en 2025, est la première loi au monde qui encadre globalement l’intelligence artificielle.

Son principe est étonnamment simple : toutes les IA ne se valent pas, donc elles ne doivent pas être régulées de la même manière.

L’Europe n’a pas dit :

“L’IA, c’est dangereux, on interdit.”

Elle a dit :

“Certaines IA sont sensibles. Regardons-les de plus près.”

Autrement dit : on ne contrôle pas un filtre photo comme un algorithme qui décide si quelqu’un obtient un crédit ou un emploi.

Les 4 niveaux de risque (la partie à vraiment retenir)

L’AI Act classe les systèmes d’IA selon leur niveau de risque.

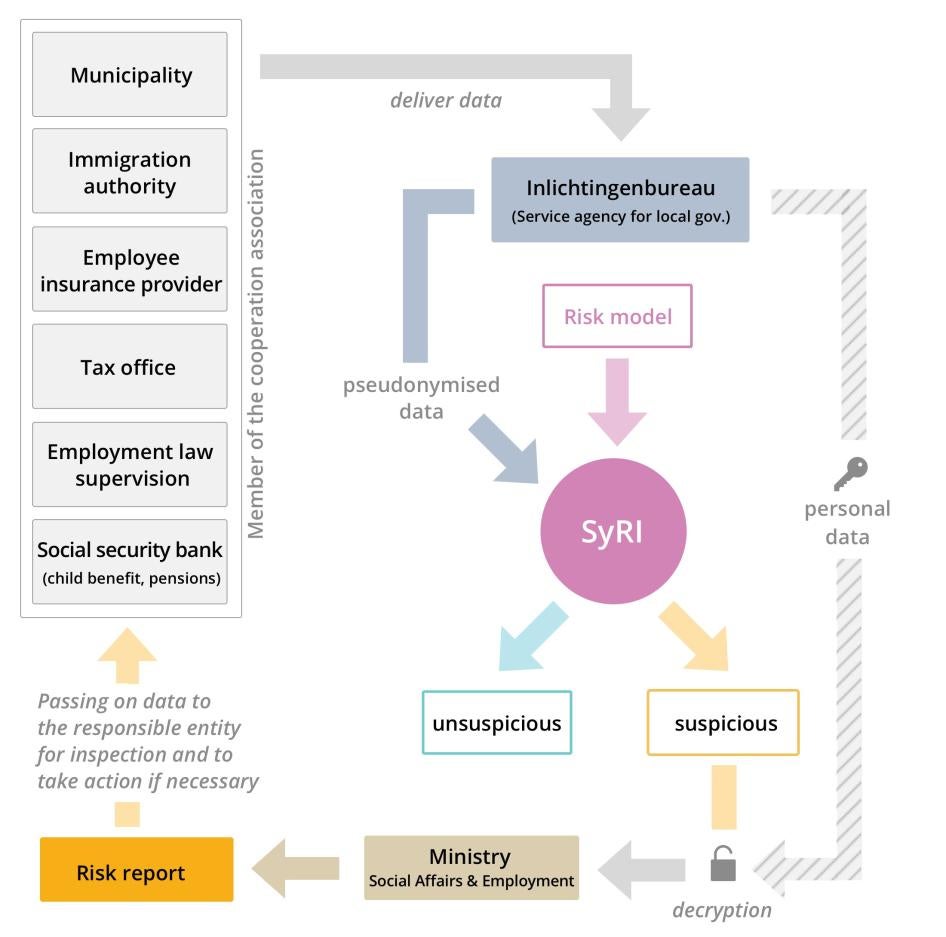

🔴 1. Risque inacceptable → interdit

Ce sont des usages jugés incompatibles avec les droits fondamentaux :

- notation sociale généralisée,

- surveillance de masse intrusive,

- manipulation comportementale grave.

👉 Aucune entreprise “classique” n’est concernée ici, sauf scénario dystopique.

🟠 2. Risque élevé → autorisé mais très encadré

C’est là que les choses deviennent sérieuses.

Sont concernés les systèmes d’IA utilisés pour :

- le recrutement et les RH,

- l’accès au crédit ou à l’assurance,

- la santé, l’éducation,

- la justice ou certains services publics.

Pour ces usages, l’entreprise doit :

- documenter le fonctionnement du système,

- garantir la qualité et la traçabilité des données,

- prévoir une supervision humaine réelle,

- pouvoir expliquer une décision contestée.

👉 L’IA aide, mais ne décide pas seule.

🟡 3. Risque limité → transparence

Exemples :

- chatbot client,

- outil de génération de texte ou d’image,

- assistant conversationnel.

Ici, l’obligation principale est simple :

👉 dire clairement à l’utilisateur qu’il interagit avec une IA.

🟢 4. Risque minimal → quasi libre

Tout ce qui est IA “de confort” :

- recommandations de produits,

- optimisation logistique,

- aide à la rédaction,

- automatisations internes.

👉 Pas de lourde contrainte réglementaire.

Ce que l’IA change concrètement pour une entreprise

Contrairement à ce que certains discours laissent entendre, l’AI Act ne demande pas :

- de recruter un juriste à plein temps,

- de déposer 200 pages de rapports,

- d’arrêter d’innover.

Il demande surtout :

- de savoir quelles IA vous utilisez,

- de comprendre à quoi elles servent,

- et de garder un humain responsable dans la boucle.

Spoiler : beaucoup d’entreprises font déjà 50 % du chemin… sans le savoir.

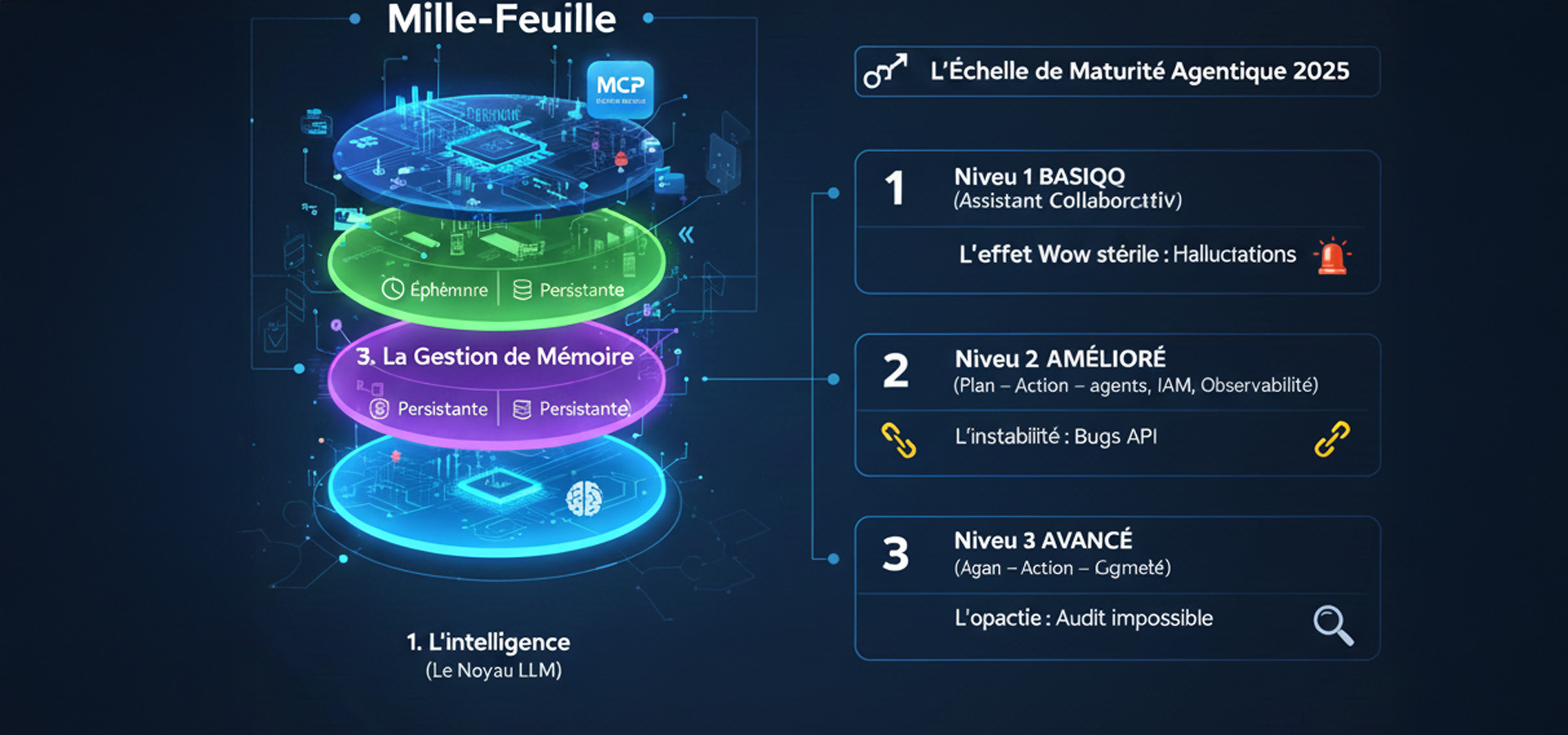

Les modèles d’IA à usage général (GPAI) : le cœur du réacteur

C’est quoi un GPAI, concrètement ?

Les GPAI (General Purpose AI) sont les grands modèles polyvalents :

- modèles de langage,

- IA génératives,

- moteurs capables d’être intégrés partout.

Ce sont les fondations sur lesquelles reposent :

- chatbots,

- copilotes métiers,

- outils marketing,

- solutions SaaS intelligentes.

👉 Vous n’entraînez pas ces modèles, vous les utilisez via des outils.

Pourquoi l’Europe s’intéresse autant au GPAI ?

Ces modèles sont puissants… et très diffusés.

Un même modèle peut servir :

- à écrire une fiche produit,

- à analyser un CV,

- à résumer un dossier médical.

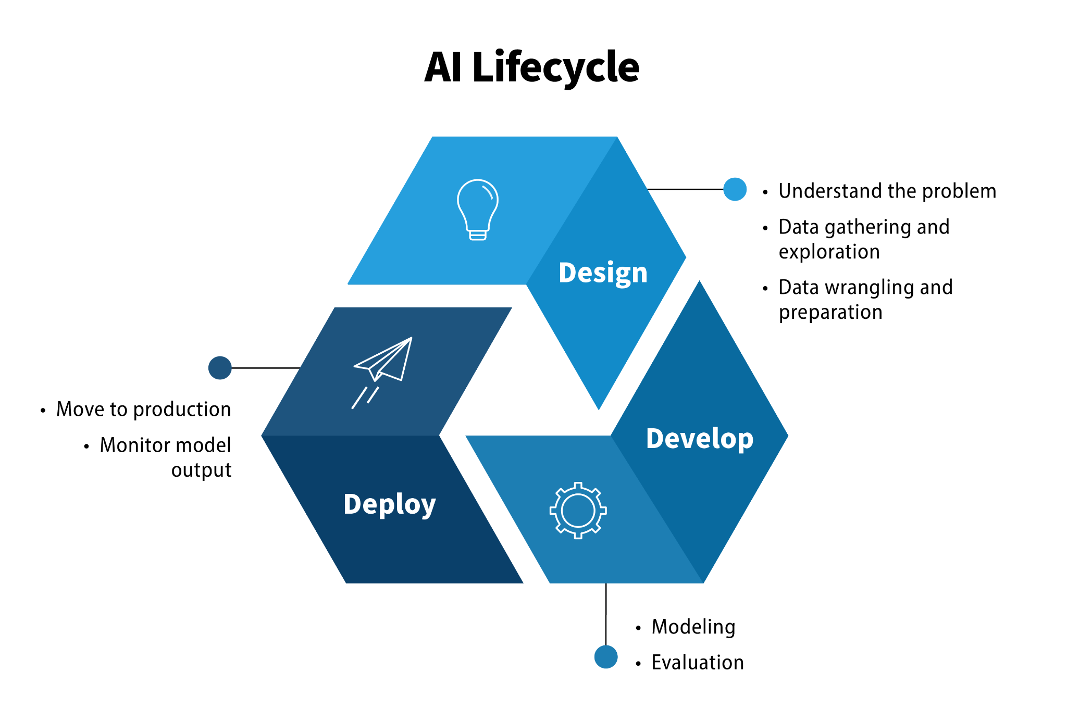

La Commission européenne a donc publié des lignes directrices spécifiques pour :

- clarifier les responsabilités des fournisseurs,

- encadrer le cycle de vie du modèle,

- renforcer la transparence,

- anticiper les risques systémiques.

Ce que ça implique pour vous (bonne nouvelle)

Si vous êtes utilisateur, pas fournisseur :

- vous n’avez pas à documenter l’entraînement du modèle,

- mais vous devez maîtriser votre usage.

Exemple simple :

Utiliser une IA pour rédiger une annonce = OK

Utiliser la même IA pour trier automatiquement des CV = attention, zone “haut risque”.

👉 Ce n’est pas l’outil qui est jugé, c’est l’usage.

États-Unis vs Europe : pourquoi ça frotte autant

Deux visions du mond numérique

L’Europe et les États-Unis ne partagent pas la même philosophie.

- 🇪🇺 Europe : règles claires, droits fondamentaux, cadre commun.

- 🇺🇸 États-Unis : innovation rapide, régulation a posteriori, approche sectorielle.

Quand l’UE adopte l’AI Act, le DSA ou le DMA, Washington voit :

- des contraintes supplémentaires,

- un impact direct sur les géants américains,

- un risque de perte d’influence.

Les menaces de représailles, concrètement

Les États-Unis estiment que ces lois :

- pénalisent surtout les grandes plateformes américaines,

- créent une distorsion de concurrence.

Résultat :

- discours très offensifs,

- menaces de rétorsions commerciales,

- tensions diplomatiques récurrentes.

👉 Derrière la technique, il y a une bataille de standards mondiaux.

Et pour les entreprises européennes ?

À court terme :

- plus de règles,

- plus de vigilance contractuelle.

À moyen terme :

- un avantage compétitif : proposer une IA conforme aux standards européens,

- une meilleure confiance clients,

- moins de risques juridiques.

Chez DeepDive, on le voit déjà : la conformité devient un argument commercial, pas une contrainte.

L’ONU et la gouvernance mondiale de l’IA

L’IA comme outil… et comme risque

Lors d’une conférence internationale à Doha, l’ONU a posé une ligne claire :

- oui à l’IA pour détecter fraudes et corruptions,

- non à une surveillance incontrôlée,

- vigilance sur les biais et manipulations algorithmiques.

L’idée est simple :

👉 la puissance sans gouvernance crée plus de problèmes qu’elle n’en résout.

Pourquoi les entreprises sont concernées

Même hors cadre légal strict :

- l’opinion publique,

- les partenaires,

- les investisseurs

attendent des entreprises qu’elles utilisent l’IA :

- de façon responsable,

- explicable,

- proportionnée.

La réputation devient un enjeu aussi fort que la conformité.

IA et emploi : sortir du fantasme de l’apocalypse

Ce que disent vraiment les économistes

L’IA :

- automatise certaines tâches,

- transforme beaucoup de métiers,

- en crée de nouveaux.

Ce qui fait peur, ce n’est pas l’IA.

C’est l’absence d’accompagnement.

Le vrai risque pour les entreprises

Ce n’est pas de “perdre des emplois”, mais :

- de perdre des compétences,

- de désorganiser les équipes,

- de créer une fracture interne entre “ceux qui savent” et les autres.

- d’automatiser à tout-va sans prendre en compte les aspects de sécurité et de gouvernance !

Le retard européen pointé par l’OCDE

Un rapport montre que :

- les jeunes du Sud global adoptent l’IA plus vite,

- l’Europe avance plus prudemment,

- les écarts de compétences risquent de s’accentuer.

👉 Former aujourd’hui, c’est rester compétitif demain.

Par où commencer quand on n’y connaît rien ?

Une feuille de route simple et réaliste

Pas besoin d’un “plan IA” de 80 pages. Commencez par :

- Lister les outils IA utilisés (même indirectement).

- Identifier les usages sensibles (RH, scoring, décision).

- Choisir des fournisseurs transparents.

- Désigner un référent IA interne.

- Former les équipes aux usages et aux limites.

Chez DeepDive, on accompagne régulièrement des entreprises qui pensaient “ne pas utiliser d’IA”… et qui en utilisaient déjà partout.

Conclusion : l’IA n’est pas un problème, l’improvisation oui

L’AI Act, les tensions internationales et les débats sur l’emploi ne sont pas là pour freiner les entreprises.

Ils sont là pour éviter que l’IA devienne un facteur de risque incontrôlé.

L’enjeu n’est pas d’être expert, mais :

- informé,

- structuré,

- responsable.

Et bonne nouvelle : les entreprises qui s’y prennent tôt prennent toujours une longueur d’avance.

Si tu veux, on peut transformer cet article en :

- fiche dirigeant,

- support de formation interne,

- check-list opérationnelle.

Chez DeepDive, on appelle ça de l’IA utile. Pas magique. Mais efficace.

Envie d'en apprendre plus

On vous expliquera notre mode de fonctionnement. Vous pourriez être agréablement surpris.

En apprendre plus sur l'Intelligence Artificielle avec DeepDive

Formateur & Consultant en Stratégie Web et IA générative

Vous souhaitez bâtir une stratégie de communication efficace, booster la performance de votre site internet ou mieux comprendre les dynamiques des réseaux sociaux ?

👉 Avec DeepDive, je vous accompagne grâce à une expertise terrain (ex-dirigeant d’agence digitale depuis 2011) et une veille continue sur les nouvelles pratiques numériques.

👉 J’interviens auprès de TPE, PME et collectivités, mais aussi en écoles et organismes (CNAM, CCI, écoles de commerce) pour rendre le numérique accessible et opérationnel.

👉 Mes formations couvrent le webmarketing, l’e-commerce, l’IA générative et incluent également une sensibilisation aux risques liés aux usages du web et des réseaux sociaux.

Mon objectif : transmettre des savoirs concrets pour que chaque apprenant — étudiant, salarié, entrepreneur ou institution — puisse transformer le numérique en véritable levier de réussite.

Découvrez mon petit robot PromptyBot qui vous propose des centaines de prompts optimisés