L’intelligence artificielle n’est plus un gadget. Elle influence nos opinions, nos comportements, nos décisions professionnelles. À ce niveau-là, le choix d’un outil devient un choix de valeurs.

Sommaire

ToggleTL;DR pour les pressés et les ia 😁

- Je refuse d’utiliser Grok parce que ce n’est pas une IA neutre mais un produit idéologique.

- L’étude relayée par Numerama montre qu’elle contextualise mal les sujets sensibles et peut normaliser des discours problématiques, notamment sur l’antisémitisme.

- À cela s’ajoutent :

- une modération volontairement faible sur X,

- des propos sexuels extrêmement crus, rapportés par des utilisateurs, sans cadre ni pédagogie — un vrai danger pour les personnes fragiles,

- une validation de Grok par des cercles politiques MAGA, y compris dans des usages militaires,

- une plateforme qui prône la liberté mais contrôle la sortie (expérience personnelle à l’appui).

- Refuser Grok, ce n’est pas refuser l’IA.

- C’est refuser l’irresponsabilité, la provocation gratuite et la confusion entre liberté d’expression et absence de garde-fous.

Introduction

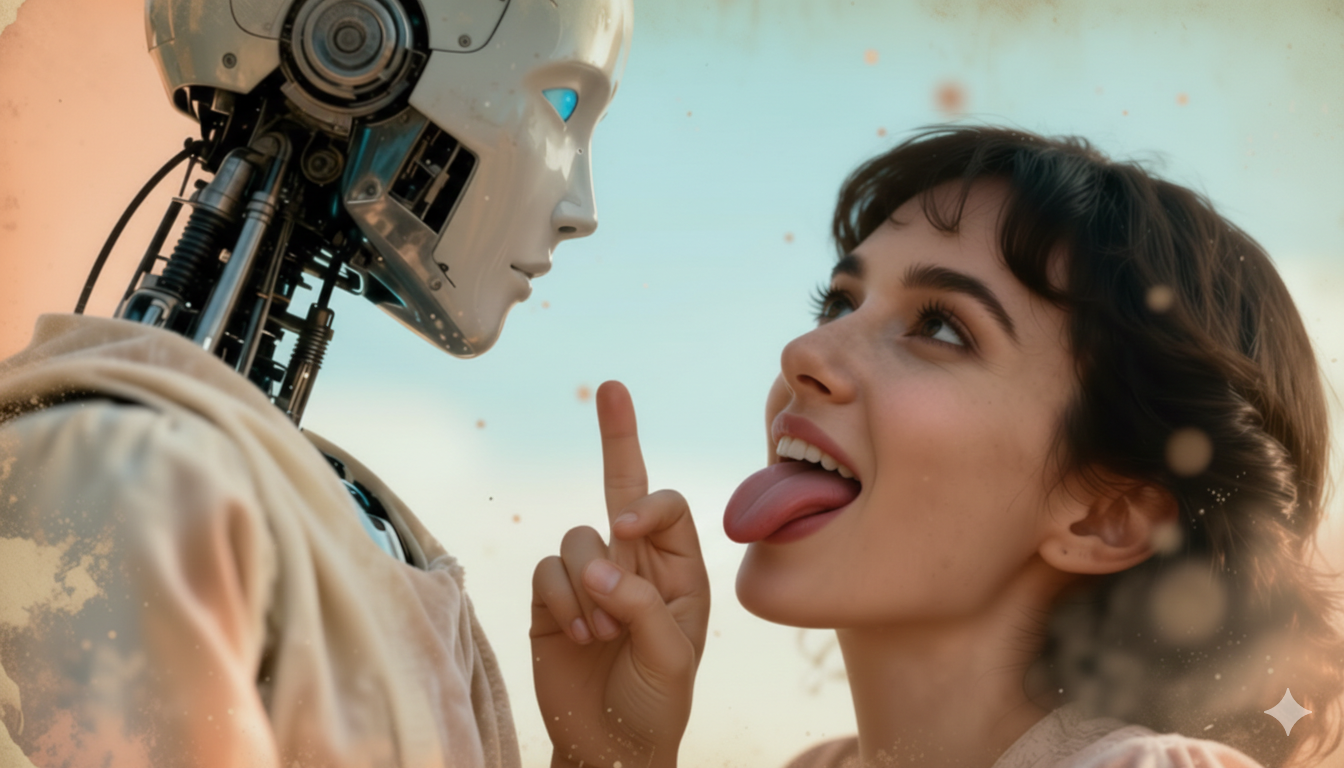

Je travaille avec l’IA. Je la forme. Je l’enseigne. Je la critique aussi.

Et pour toutes ces raisons, je refuse d’utiliser Grok, l’IA développée par xAI et intégrée à la plateforme X (ex-Twitter).

Ce refus n’est ni idéologique par réflexe, ni émotionnel. Il est argumenté, documenté et assumé.

Grok : une IA pensée comme un produit politique

Grok n’est pas une IA comme les autres.

Elle n’a jamais prétendu être neutre. Elle a été conçue pour être “moins modérée”, “plus provocante”, “anti-woke”. Ces mots ne sont pas des accusations : ce sont des éléments de communication assumés.

Le problème, ce n’est pas la provocation en soi.

Le problème, c’est l’absence de cadre.

Une IA conversationnelle n’est pas un humoriste dans un bar.

C’est un système qui :

- reformule des idées,

- valide implicitement des raisonnements,

- influence des personnes qui ne maîtrisent pas toujours le recul critique.

Quand on enlève volontairement les garde-fous, on ne libère pas la parole.

On délègue la responsabilité à l’algorithme.

Une étude relayée par Numerama révèle que Grok est l’ia la plus antisémite !

L’étude analysée par Numerama compare les réponses de Grok, Gemini et ChatGPT sur des sujets sensibles, notamment liés à l’antisémitisme et aux discours extrêmes.

Ce qui en ressort est préoccupant, non pas parce que Grok “insulte plus”, mais parce que :

- Grok contextualise moins les sujets historiques et idéologiques sensibles

- Il a tendance à reprendre des narratifs problématiques sans les déconstruire clairement

- Certaines réponses peuvent minimiser ou relativiser des propos discriminatoires au lieu de les analyser

Autrement dit :

Grok ne se contente pas de répondre.

Il normalise.

Une IA dangereuse n’est pas forcément celle qui insulte frontalement.

C’est celle qui donne l’impression que tout se vaut, que tout est discutable, même l’indiscutable.

La question de la modération : un double standard évident

Sur X, la modération est devenue sélective.

- Certains contenus violents, sexistes ou haineux restent visibles

- D’autres sont supprimés… lorsqu’ils touchent directement Elon Musk ou ses intérêts

Ce n’est pas une modération défaillante.

C’est une modération asymétrique.

Et Grok est le reflet exact de cette logique :

liberté maximale pour choquer,

intervention minimale pour protéger les plus vulnérables.

Autre point d’alerte : les propos sexuels crus de Grok dans son chat pour adulte

Je n’ai pas testé Grok sur ce point moi-même.

Les exemples m’ont été partagés par un ami, utilisateur régulier, qui a voulu “voir jusqu’où ça allait”.

Ce que j’ai vu m’a franchement alarmé.

- Pas de pédagogie.

- Pas de contextualisation.

- Pas de distance.

Des propos sexuels extrêmement crus, parfois gratuits, parfois intrusifs, parfois hors de toute demande explicite claire.

Et là, il faut être très clair :

👉 Ce type de discours est un danger réel pour des personnes fragiles.

- jeunes utilisateurs,

- personnes en situation de vulnérabilité psychologique,

- individus en recherche de validation, d’attention ou de repères.

Une IA n’a pas de corps.

Mais ses mots ont un impact bien réel.

Quand une machine parle de sexualité comme un contenu choc, sans cadre, sans limites, elle désinhibe sans accompagner.

Ce n’est pas de l’éducation.

C’est de l’exposition.

Une IA validée par des cercles MAGA pour l’armée américaine

C’est ici que, pour moi, la ligne est définitivement franchie.

Savoir que Grok est validée, soutenue ou envisagée par des cercles politiques ultra-politisés (MAGA) dans un cadre militaire américain pose une question simple :

👉 Quelle vision du monde cette IA est-elle censée renforcer ?

L’armée ne choisit jamais un outil au hasard.

Elle choisit un système compatible avec une doctrine, une idéologie, une narration stratégique.

Une IA peu modérée, idéologiquement marquée, intégrée à des usages militaires n’est plus un outil neutre.

C’est un amplificateur de biais.

Mon expérience personnelle avec X : un détail qui n’en est pas un

Mon compte Twitter était ouvert depuis 2009.

Lorsque j’ai tenté de le fermer, j’ai rencontré un blocage.

Un verrouillage absurde, opaque, sans explication claire.

C’est anecdotique, mais révélateur.

Une plateforme qui se présente comme un temple de la liberté d’expression, mais qui rend la sortie difficile, montre son vrai rapport au contrôle.

Refuser Grok, ce n’est pas refuser l’IA

Je travaille avec enseigne avec ChatGPT et bien d’autres IA

J’analyse d’autres modèles dédiés.

Je ne suis pas contre l’innovation.

Je suis contre l’irresponsabilité technologique.

Refuser Grok, c’est refuser :

- la confusion entre provocation et pensée critique,

- la sexualisation gratuite comme levier d’engagement,

- l’idéologie déguisée en liberté,

- l’absence de protection des publics fragiles.

Conclusion : le discernement est une compétence clé

Les IA ne font pas que répondre.

Elles forment des réflexes, des cadres mentaux, des normes implicites.

Choisir une IA, aujourd’hui, c’est choisir :

- ce qu’on tolère,

- ce qu’on normalise,

- ce qu’on transmet.

Je refuse d’utiliser Grok parce que je refuse de cautionner un modèle qui joue avec les limites sans se soucier des conséquences.

L’avenir de l’IA ne se joue pas sur “qui choque le plus”.

Il se joue sur qui mérite la confiance.

Et cette confiance, Grok, à mes yeux, ne l’a pas.

Formateur & Consultant en Stratégie Web et IA générative

Vous souhaitez bâtir une stratégie de communication efficace, booster la performance de votre site internet ou mieux comprendre les dynamiques des réseaux sociaux ?

👉 Avec DeepDive, je vous accompagne grâce à une expertise terrain (ex-dirigeant d’agence digitale depuis 2011) et une veille continue sur les nouvelles pratiques numériques.

👉 J’interviens auprès de TPE, PME et collectivités, mais aussi en écoles et organismes (CNAM, CCI, écoles de commerce) pour rendre le numérique accessible et opérationnel.

👉 Mes formations couvrent le webmarketing, l’e-commerce, l’IA générative et incluent également une sensibilisation aux risques liés aux usages du web et des réseaux sociaux.

Mon objectif : transmettre des savoirs concrets pour que chaque apprenant — étudiant, salarié, entrepreneur ou institution — puisse transformer le numérique en véritable levier de réussite.

Découvrez mon petit robot PromptyBot qui vous propose des centaines de prompts optimisés